Dies ist ein Gastbeitrag von Alec Coughlin. Alec hilft Führungskräften in Unternehmen, den KI‑Hype und Agenten‑Washing zu durchschauen und sich auf das zu konzentrieren, was tatsächlich geschäftlichen Mehrwert schafft. Er ist Gastgeber von „AI with Alec“, einem Podcast und einer Thought-Leadership-Plattform, die pragmatische Orientierung zur unternehmensweiten KI-Transformation bietet.

Die Transformation von Enterprise-AI ist voller Lärm. Um von Lärm zu Signalen zu gelangen, gibt es vier Dinge, auf die sich jeder CEO konzentrieren sollte, ohne etwas falsch zu machen.

1. Vom anwendungs- zum daten- zum wissenszentrierten Architekturmodell

Laut einer Umfrage von Dataiku und Harris Poll, dem „Global AI Confessions Report: CEO Edition“, geben 74 % der US-CEOs zu, dass sie ihren Job innerhalb von zwei Jahren verlieren werden, wenn sie keinen messbaren geschäftlichen Nutzen aus KI liefern.

Darüber hinaus glauben 82 % der CEOs, dass KI in den nächsten drei Jahren ein entscheidender Wettbewerbsvorteil sein wird. Doch heute geben CEOs zu, dass 35 % ihrer KI-Initiativen eher auf Optik als auf Wirkung ausgerichtet sind („AI Washing“), um Innovation zu signalisieren und den Ruf zu verbessern, anstatt echten geschäftlichen Mehrwert zu schaffen.

Was sollte ein CEO also tun, um seinen Job nicht in zwei Jahren zu verlieren? Wie vermeiden sie „AI Washing“ und investieren stattdessen in den Aufbau eines soliden Fundaments, um ihr Geschäft zukunftssicher zu machen, indem sie sofort und langfristig „echten geschäftlichen Nutzen“ liefern?

Sie sollten erkennen, wie bedeutend der Unternehmenswandel von einer anwendungs- zu einer daten- zu einer wissenszentrierten Architektur ist, der heute durch große Sprachmodelle (LLMs) ermöglicht wird, und in die Modernisierung ihres Technologie- und Datenstapels investieren, um davon zu profitieren.

Vor dem Aufkommen von LLMs wurden Datenbanken so aufgebaut, dass SaaS-Anwendungen einen spezifischen Mehrwert schaffen konnten, indem sie ein bestimmtes Problem lösten und entsprechende Ergebnisse generierten. Leider entstanden dadurch Datensilos, da Anwendungen in der Regel nicht miteinander kommunizierten.

Infolgedessen waren Daten über denselben Prozess, Kunden, Interessenten, Mitarbeiter usw. in einer Anwendung redundant zu den Daten in einer anderen Anwendung – ohne eine skalierbare Möglichkeit, diese zu vereinheitlichen. LLMs haben all das verändert.

Dank LLMs und ihrer Fähigkeit, Sprache, Daten usw. zu verstehen, scheint es, als würden alle Mauern, die zwischen SaaS-Anwendungen errichtet wurden, nun eingerissen. Dadurch können die Daten in einer Anwendung mit den Daten in einer anderen kommunizieren, was wiederum vollständigere und reichhaltigere Datensätze ermöglicht.

Diese Transformation wirkt sich auf die gesamte Wertschöpfungskette aus – insbesondere, wenn Unternehmen KI-Agenten in ihren Betrieb einführen. LLMs dienen als Basistechnologie für diesen architektonischen Wandel. Sie fungieren als kognitive Grundlage, die durch intelligentere Entscheidungsfindung und Systeme den Übergang von einer anwendungszentrierten zu einer datenzentrierten Architektur ermöglicht.

Pionierunternehmen entwickeln sich bereits weiter zu einer wissenszentrierten Architektur, in der Ontologien durch Wissensgraphen operationalisiert werden – und so das volle Potenzial der Zusammenarbeit zwischen Mensch und KI-Agenten im großen Maßstab freisetzen.

Dieser architektonische Wandel führt direkt zum zweiten zentralen Fokusbereich: dem Übergang von deterministischen zu probabilistischen Anwendungen.

2. KI ersetzt Software: Deterministische vs. probabilistische Anwendungen

„Wie viele der SaaS-Anwendungen, auf die wir derzeit als Unternehmen angewiesen sind, werden in 18–24 Monaten noch existieren?“

Diese Frage ist nicht nur real, sie wurde mir in letzter Zeit von mehreren Führungskräften aus Fortune-1000-Unternehmen gestellt. Es ist eine ausgezeichnete, aber sehr schwer zu beantwortende Frage – und steht im Zentrum der komplexen Entscheidung zwischen „Kaufen vs. Bauen vs. Partnerschaften“ für Unternehmensentscheider.

Deterministische Anwendungen sind das Herzstück einer anwendungszentrierten Architektur. Vereinfacht gesagt sind dies Anwendungen, die ausschließlich für eine vordefinierte Nutzung mit einer begrenzten Anzahl von Anwendungsfällen ausgelegt sind.

Probabilistische Anwendungen hingegen basieren im Kern auf LLMs, die sie intelligent machen. Im Gegensatz zu den oben genannten Einschränkungen haben sie die Fähigkeit zu denken, sich anzupassen und weitere Fähigkeiten zu entwickeln – wodurch sie mehr leisten und mit der Zeit wertvoller werden.

Das wirft eine wichtige Frage auf: Warum sollten Unternehmen weiterhin deterministische Anwendungen entwickeln, wenn probabilistische Alternativen überlegene Fähigkeiten bieten? Die Antwort liegt im Herzen der Disruption, die derzeit die traditionelle SaaS-Branche verändert.

Ein weiterer großer Vorteil probabilistischer Anwendungen ist, dass sie bei jeder Nutzung dazulernen, sich anpassen und weiterentwickeln. Dadurch schaffen sie mehr Mehrwert für den nächsten Benutzer oder KI-Agenten und verstärken gleichzeitig die Wirkung der Agenten auf menschliche Arbeitsabläufe.

3. Unternehmens-KI-Agenten ergänzen Menschen – quasi Superkräfte

Was ist der schnellste und vielleicht risikoärmste Weg, um aus der Zusammenarbeit zwischen Menschen und Unternehmens-KI-Agenten Wert zu schöpfen?

Wie Jeff Bezos sagte: Konzentriere dich auf das, was sich nicht ändert. Er sagte:

„Ich bekomme sehr häufig die Frage: ‚Was wird sich in den nächsten 10 Jahren ändern?‘ Und das ist eine interessante Frage – aber ich bekomme fast nie die Frage: ‚Was wird sich in den nächsten 10 Jahren nicht ändern?‘

Und ich behaupte, dass die zweite Frage eigentlich die wichtigere ist. Denn man kann eine Geschäftsstrategie rund um Dinge aufbauen, die langfristig stabil bleiben ... Wenn etwas auf lange Sicht wahr bleibt, kann man dort viel Energie investieren.“

Es wird immer deutlicher, dass kleine, funktionsübergreifende Teams, unterstützt durch einen KI-zentrierten Tech-Stack, Ergebnisse liefern können, die um ein Vielfaches größer sind als die traditioneller Teams. Gleichzeitig ist klar geworden, dass es eine breite Spanne von Erfolgen und Misserfolgen bei unternehmensweiten KI-Agenten gegeben hat. Bezos’ Punkt folgend: Fokussiere dich auf das, was sich nicht ändert.

Operationalisiere einen KI-zentrierten Ansatz, indem du kleine, funktionsübergreifende Teams schaffst, die sich auf stabile Geschäftsziele konzentrieren, auf einem KI-zentrierten Stack arbeiten und mit einem kollaborativen Set von Unternehmens-KI-Agenten auf einer daten- oder wissenszentrierten Architektur kooperieren.

Hier entsteht echter Wettbewerbsvorteil: Pionierunternehmen können sich Moats (Schutzgräben) aufbauen, die sich exponentiell vergrößern, da diese intelligenten Systeme mit jeder Interaktion wertvoller werden und sich die Vorteile mit der Zeit vervielfachen.

4. Ein Beispiel? Gib deinem B2B-GTM-Team Superkräfte

Es gibt eine große Lücke zwischen den technologischen Möglichkeiten von Unternehmens-KI und ihrer tatsächlichen Nutzung. Ein drastisches Beispiel ist der Unterschied zwischen der heutigen traditionellen B2B-GTM-Vorgehensweise und dem, was möglich ist, wenn moderne, KI-zentrierte Methoden und Tech-Stacks genutzt werden.

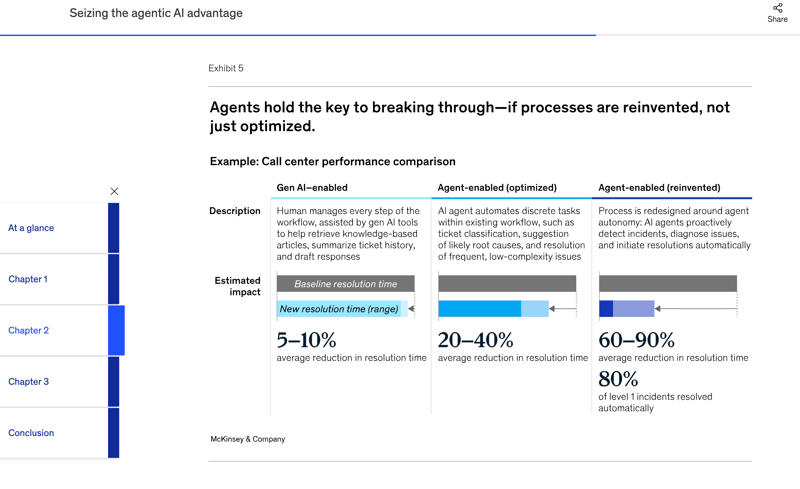

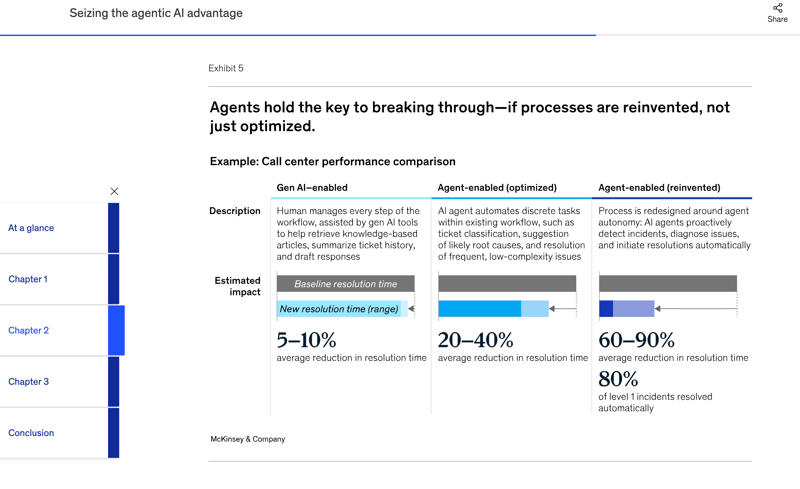

Laut „Seizing the Agentic AI Advantage“ von McKinsey:

„Organisationen müssen beginnen, ihre IT-Architekturen rund um ein Agent-First-Modell neu zu denken, bei dem Benutzeroberflächen, Logik- und Datenzugriffsschichten nativ für Maschineninteraktion und nicht für menschliche Navigation ausgelegt sind. In einem solchen Modell sind Systeme nicht mehr um Bildschirme und Formulare herum organisiert, sondern um maschinenlesbare Schnittstellen, autonome Workflows und agentenbasierte Entscheidungsflüsse.“

Ich glaube, dass alle B2B‑Unternehmen ein LLM‑basiertes Betriebssystem schaffen werden, auf dem kleine funktionsübergreifende Teams gemeinsam mit KI‑Agenten Ergebnisse erzielen, für die früher Teams mit drei bis fünf Mal so vielen Mitgliedern nötig waren.

Basierend auf einer leichtgewichtigen Sichtweise („POV“), die ich bereits für ontologie‑bewusste intelligente Systeme veröffentlicht habe („Becoming an AI‑First Company: Ontology Aware Intelligent System, GTM Use Case“), unterstützt durch meinen aktuellen Newsletter zu diesem Thema geschehen magische Dinge, wenn Definitionen, Beziehungen und Geschäftskontext, die notwendig sind, damit KI‑Agenten das Geschäft „verstehen“ können, näher an die Daten gelangen.

Die Ausführungsgeschwindigkeit wird durch robuste Datenmodellierung und semantische Schichten erhöht, die der KI die „Business‑Wahrheit“ liefern. Das ermöglicht es, schneller qualitativ hochwertige Sales‑Pipelines zu generieren und größere Abschlüsse über kürzere Verkaufszyklen abzuschließen.

Und nicht zuletzt erlaubt dieses intelligente System und die Zusammenarbeit zwischen Menschen und KI‑Agenten den Menschen, sich auf die Elemente des Go-to-Market (GTM) zu konzentrieren, in denen wir am besten sind, auf eine Weise, die vor dem Aufkommen von ChatGPT undenkbar gewesen wäre.

Wie Kurt Muehmel, Head of AI Strategy bei Dataiku, in seinem jüngsten Auftritt bei „AI with Alec“ sagte: „Ich glaube, dass wir unweigerlich auf eine hybride Mensch‑Agent‑Arbeitswelt zusteuern, und wir brauchen dafür sowohl die passenden Werkzeuge als auch das richtige Mindset in den Unternehmen.“

Wenn Sie mehr erfahren möchten, besuchen Sie AIwithAlec.com, abonnieren Sie meinen Newsletter oder meinen YouTube‑Kanal oder folgen Sie mir auf LinkedIn und X.